Co to crawl budget? Jak działa ten mechanizm i jak go zoptymalizować?

Crawl budget decyduje o potencjale indeksacji Twojej witryny. Jeżeli chcesz wiedzieć, jak zoptymalizować budżet indeksowania w taki sposób, aby Twój serwis był stale widoczny w organicznych wynikach wyszukiwania, przeczytaj nasz artykuł.

Z tego wpisu dowiesz się:

- Czym jest crawl budget?

- Dlaczego budżet indeksowania jest ważny?

- Co wpływa na Google crawl budget?

- Jak sprawdzić Google budget w Google Search Console i Ahrefs?

- Jak zoptymalizować SEO crawl budget w 10 prostych krokach?

Zachęcamy do przeczytania jednego z najbardziej istotnych wpisów w zakresie widoczności witryn w wyszukiwarce Google. W razie pytań pozostajemy do dyspozycji.

Co to jest crawl budget?

Crawl budget to termin używany w SEO, odnoszący się do liczby podstron, które roboty wyszukiwarki (Googleboty, crawlery, spidery lub pająki), są w stanie zeskanować i zaindeksować w określonym czasie.

Google przydziela budżet indeksowania, bazując na różnych czynnikach, takich jak:

- częstotliwość aktualizacji strony,

- jej autorytet,

- wydajność,

- i wiele innych.

Nieoptymalny crawl budget, wynikający z błędów serwera, blokad w robots.txt czy duplikatów treści, ogranicza zazwyczaj widoczność strony w wynikach wyszukiwania.

Dlaczego crawl budget Google jest ważny?

John Mu (Senior Webmaster Trends Analyst w Google) w licznych wypowiedziach na swoim Twitterze oraz podcastach Google (np. „Should i worry about crawl budget?”), twierdzi, że crawl-budget jest brany pod uwagę zbyt poważnie. Wiele stron internetowych po prostu nie powinno się nim martwić. To bardzo interesujący temat, ale w przypadku przedsiębiorców posiadających tzw. multi-billion URL sites. Dla przeciętnego CEO dowolnego serwisu jest to ważne zdecydowanie mniej.

Jeżeli chcesz posłuchać najnowszego podcastu o crawl budgecie z 25 sierpnia 2022 roku, wejdź w ten link: goo.gle/sotr045.

Zdj 1. Podcast Google Search Central na temat crawl budget. Źródło: www.twitter.com/JohnMu/status/1562858161739948034

Google crawl budget – co na niego wpływa?

Co wpływa na crawl budget?

- limit współczynnika indeksacji – Google przypisuje każdej stronie internetowej budżet indeksowania, który określa, ile stron robot Google może zeskanować każdego dnia. Witryny z większym ruchem miesięcznym i częstszymi aktualizacjami otrzymują zazwyczaj bardziej znaczące budżety;

- częstotliwość indeksacji (tzw. crawl demand) – Google bierze pod uwagę popularność i częstotliwość aktualizacji strony, aby ustalić, jak często powinien ją skanować. Strony regularnie aktualizowane, z większą liczbą internal linków, mają wyższy crawl demand (nie stanowi to jednak reguły);

- kondycja crawli (tzw. crawl health) – strony z błędami serwera (5xx) lub strony niedostępne (4xx), mogą negatywnie wpłynąć na health crawl, co będzie się wiązało z mniejszym budżetem indeksowania;

- kody odpowiedzi serwera – kody odpowiedzi 2xx są pozytywne, ale kody 4xx i 5xx powodują najczęściej minimalizację budżetu indeksowania. Wynika to z prostego powodu: roboty tracą czas na próby dostępu do stron, które są niedostępne;

- blokady w pliku robots.txt – blokowanie dostępu do pewnych sekcji strony w pliku robots.txt ogranicza zużycie budżetu indeksowania na nieistotnych lub ukrytych podstronach (np. cookies, RODO);

- wydajność serwera – jeśli serwer jest wolny lub niestabilny, roboty Google mogą wolniej indeksować serwisy. Przekłada się to na mniejszy crawl budget;

- duplicate content – duplikaty treści powodują, że roboty Google spędzają zbyt wiele czasu na indeksowaniu tych samych informacji. Zmniejsza to efektywność indeksowania;

- thin content – strony o niskiej wartości i małej ilości treści (thin content) są mniej atrakcyjne dla Google, skłaniając roboty do zmniejszenia częstotliwości skanowania.

Crawl budget Google Search Console – jak sprawdzić?

W tym celu należy wejść Ustawienia → Statystyki indeksowania → Otwórz raport z ostatnich 90 dni.

Zdj 2. Weryfikacja crawl budget Google Search Console.

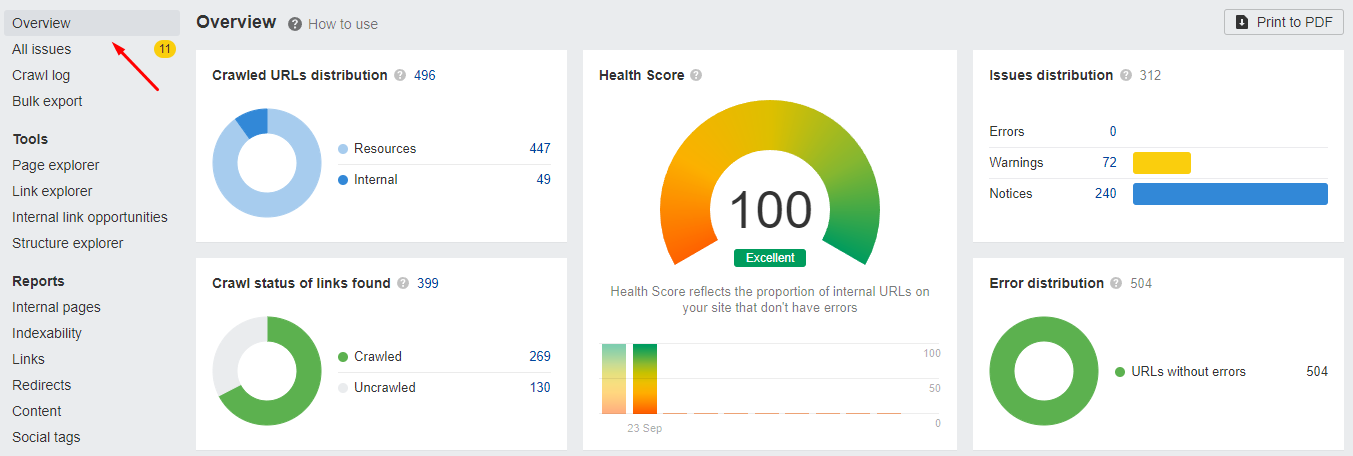

Jeżeli chcesz dodatkowo zweryfikować stan swojej witryny pod kątem crawlowania (np. w zakresie znalezionych linków), możesz skorzystać z Ahrefs. Wejdź w Site Audit, stwórz nowy projekt i wybierz odpowiednią stronę, a następnie kliknij Overview.

Zdj 3. Weryfikacja stanu crawlowania linków w Ahrefs.

Bardzo dobry rozwiązaniem jest także opcja Crawl log. Przedstawia, kiedy crawlery zweryfikowały konkretne adresy URL, podając ich konkretne źródło.

Zdj 4. Crawl log Ahrefs.

SEO crawl budget – optymalizacja w 10 prostych krokach

Jak zoptymalizować crawl budget w 10 prostych krokach?

- Wyeliminuj błędy 404/410. Błędy 404 wskazują na brak zasobu, a 410 oznaczają, że zasób został stale usunięty. Aby zidentyfikować i wyeliminować te błędy, zapewniając poprawną nawigację i dostępność stron, wykorzystaj Google Search Console;

- Usuń przekierowania z linkowania wewnętrznego. Przekierowania (np. 301) mogą spowolnić działanie Twojej strony i utrudnić robotom indeksowanie zawartości. Zidentyfikuj i zmień wszelkie linki wewnętrzne prowadzące do przekierowań, aby bezpośrednio wskazywały na docelowe podstrony.

- Sprawdź duplikaty i możliwość występowania potencjalnej kanibalizacji. Duplikacja treści i kanibalizacja słów kluczowych mogą negatywnie wpływać na pozycjonowanie strony. Użyj narzędzi SEO do zidentyfikowania i wyeliminowania duplikatów treści oraz przeanalizowania struktury strony, aby unikać konkurencji między poszczególnymi podstronami o te same słowa kluczowe.

- Zmniejsz udział adresów noindex w strukturze serwisu. Adresy oznaczone jako „noindex” są pomijane przez roboty wyszukiwarki. Jeśli Twoja strona ma zbyt wiele takich adresów, może to ograniczyć jej widoczność w wynikach wyszukiwania. Przemyśl, czy naprawdę potrzebujesz tej dyrektywy na konkretnych adresach, które są obecnie oznaczone jako noindex.

- Sprawdź pliki robots.txt i zweryfikuj, które z blokowanych adresów są nadal crawlowane. Plik robots.txt informuje roboty wyszukiwarki, które części Twojej strony mogą indeksować, a których powinny unikać. Zweryfikuj zawartość tego pliku i dopilnuj, aby nie blokował ważnych zasobów oraz sprawdź, czy roboty przestrzegają zawartych w nim dyrektyw.

- Podlinkuj najważniejsze odnośniki sitewide (na wszystkich podstronach). W tym przypadku każdy URL musi mieć jeden link wewnętrzny, który kieruje podstrony do siebie nawzajem;

- Odblokuj kluczową zawartość JS/CSS dla robota Google. Dzięki temu zmniejszysz problemy z indeksowaniem podstron. Dzięki temu Google nie będzie również marnować czasu na renderowanie niedostępnej zawartości.

- Zadbaj o poprawność wskaźników Core Web Vitals. CWV raczej wykorzystaj do konsultacji z programistami i ustalenia konkretnego celu wydajnościowego witryny, dzięki czemu będzie ona wydajna i responsywna, przez co crawlery będą indeksowały ją szybciej. Core Web Vitals jest jednym z ponad 200 czynników rankingowych, natomiast nie wpływa znacząco na pozycje. Na rynku jest zbyt wiele różnorodnych urządzeń o zmiennej jakości połączenia internetowego itd., żeby był to jeden z najbardziej istotnych czynników SEO;

- Sprawdź, czy sitemap.xml działa oraz, czy zawiera najważniejsze elementy (w tym kanoniczne adresy URL z kodem 200). Adresy, które są ustawione jako noindex lub zwracają błędy, powinny zostać usunięte z pliku.

- Warto również zweryfikować kanoniczność adresów wewnątrz serwisu. Zgodnie z najnowszymi standardami Google, znacznik rel=”canonical” nie jest istotną dyrektywą dla Google. W wielu sytuacjach wyszukiwarka ignoruje parametry sortowania, co sprawia, że są przez cały czas w indeksie.

Crawl budget – podsumowanie

Crawl budget to centralny element SEO, determinujący liczbę podstron Twojej witryny, które mogą zostać zeskanowane oraz zaindeksowane przez roboty wyszukiwarki w określonym czasie. Odpowiednia optymalizacja crawl budget jest kluczowa pod kątem efektywności SEO i pozwala regularnie indeksować wszystkie podstrony w Twoim serwisie.

Głównymi elementami wpływającymi na budżet indeksowania są m.in.:

- błędy serwera,

- blokady w robots.txt,

- duplikacja treści,

- wydajność serwera.

Poprawa powyższych aspektów (a zwłaszcza eliminacja błędów 4xx i 5xx) oraz optymalizacja wydajności serwerowej wpłyną pozytywnie na budżet indeksowania Twojej witryny.

Aby zmaksymalizować rezultaty działań SEO, zdecyduj się na profesjonalną konsultację z ekspertami SEOgroup. Pomożemy zoptymalizować Twoją witrynę pod kątem SXO (SEO + UX) i poprawimy skutecznie jej crawl budget.

Zachęcamy do wypełnienia poniższego formularza kontaktowego:

FAQ – najczęstsze pytania i odpowiedzi na temat crawl budget w SEO

Jakie są najczęstsze pytania i odpowiedzi na temat crawl budget w SEO?

Czym dokładnie jest crawl budget?

Crawl budget to liczba podstron, które robot wyszukiwarki może zeskanować i zaindeksować na Twojej stronie w określonym czasie.

Dlaczego crawl budget jest ważny?

Optymalizacja crawl budgetu zapewnia, że roboty wyszukiwarki efektywnie indeksują najważniejsze podstrony.

Jak mogę zwiększyć crawl budget?

W celu zwiększenia crawl budgetu: zoptymalizuj szybkość strony, wyeliminuj błędy serwera i błędy 4xx oraz unikaj duplicate content i potencjalnych blokad w pliku robots.txt.

Czy duplikacja treści wpływa na crawl budget?

Duplikacja treści może negatywnie wpłynąć na crawl budget, ponieważ roboty wyszukiwarki spędzają czas na indeksowaniu tych samych informacji wielokrotnie.

Jak sprawdzić, ile wynosi mój crawl budget?

Crawl budget możesz sprawdzić w Google Search Console. W tym celu wejdź w Ustawienia → Statystyki indeksowania. Następnie otwórz raport z ostatnich 90 dni.

Jakie kody odpowiedzi mają wpływ na crawl budget?

Kody odpowiedzi 4xx i 5xx mogą negatywnie wpłynąć na crawl budget, zmniejszając liczbę podstron, które mogą zostać zeskanowane i zaindeksowane określonym czasie.

Czy crawl budget różni się w zależności od wyszukiwarki?

Wyszukiwarki bazują na różnych algorytmach i mocach przerobowych. Wpływa to na potencjalne różnice w przydzielanym budżecie indeksowania.

Czy blokady w pliku robots.txt wpływają na crawl budget?

Blokady w pliku robots.txt ograniczają dostęp robotów do określonych sekcji strony, co może wpłynąć na efektywne wykorzystanie crawl budgetu. Nie zawsze jednak roboty wyszukiwarki respektują atrybut nofollow.

Czy ilość linków wewnętrznych i zewnętrznych wpływa na crawl budget?

Odpowiednia liczba linków wewnętrznych może poprawić crawl budget poprzez ułatwienie robotom dostępu do konkretnych poziomów strony. Warto również wspomnieć, iż linki zewnętrzne (tzw. internal linki) zwiększają autorytet strony w wynikach wyszukiwania.

Jak crawl budget wpływa na SEO?

Optymalny crawl budget zapewnia regularne i efektywne indeksowanie strony przez roboty wyszukiwarki. Jest to fundamentalnym aspektem pod kątem osiągnięcia wysokich pozycji w wynikach wyszukiwania na konkretne słowa kluczowe.

Nazywam się Dominik. Monetyzuję blogi i zwiększam sprzedaż w firmach.. Pracuję zdalnie, obsługując klientów ze Stanów Zjednoczonych, Wielkiej Brytanii, Norwegii oraz Polski.

Dodaj komentarz

Chcesz się przyłączyć do dyskusji?Feel free to contribute!